Nowa publikacja w IEEE Transactions on Reliability

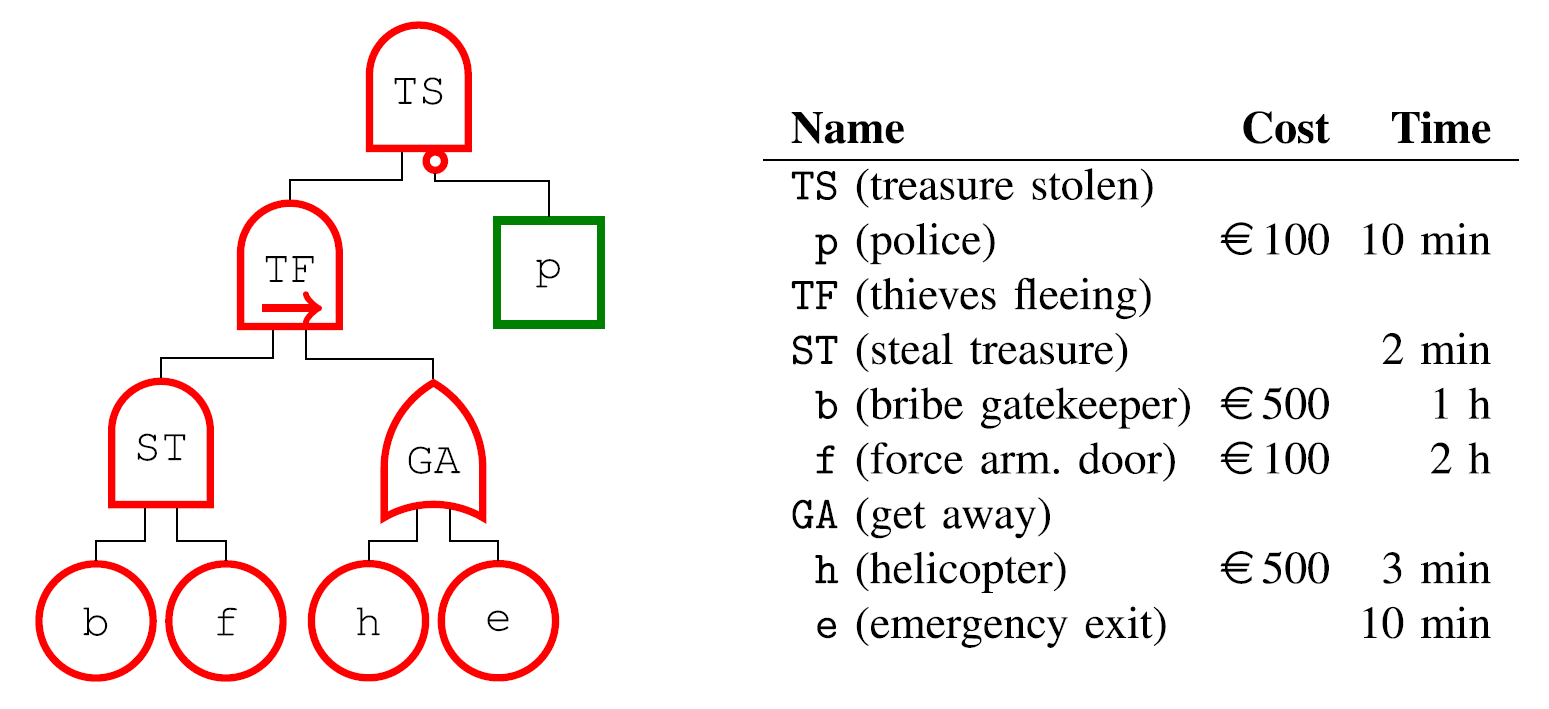

31 stycznia b.r. w czasopiśmie IEEE Transactions on Reliability został opublikowany artykuł pracowników IPI PAN: prof. Wojciecha Penczka, dr Łukasza Maśko i mgr Teofila Sidoruka, napisany we współpracy z prof. Laure Petrucci, dr Carlosem Olarte i dr Jaime Ariasem z Université Sorbonne Paris Nord. Praca "Optimal Scheduling of Agents in ADTrees: Specialized Algorithm and Declarative Models" stanowi kontynuację wcześniejszej linii badań [1], w której zaproponowano reprezentowanie drzew ataku/obrony (ADTrees) jako systemów wieloagentowych. ADTrees są popularnym formalizmem, pozwalającym na analizowanie scenariuszy bezpieczeństwa, w których dwie grupy agentów próbują albo wykonać podzadania (poszczególne węzły drzewa) składające się na główny cel (korzeń drzewa), albo dążą do uniemożliwienia tego przeciwnej grupie. Dzięki translacji do formalizmu wieloagentowego, możliwe staje się rozważanie tych dwóch grup jako koalicji, charakteryzujących się nie tylko pewną liczbą agentów, ale również konkretnym ich przydziałem do poszczególnych podzadań. To z kolei determinuje zarówno możliwość skutecznego ataku lub obrony przeciwko drugiej koalicji, ale także wpływa na rozważane cechy kwantytatywne, np. czas ataku/obrony lub związany z nimi koszt finansowy.