Artykuł o metodzie ciągłego uczenia sieci neuronowych przy przy zachowaniu gwarancji niezapominania na konferencji ICML 2022

Paweł Morawiecki z Zakładu Podstaw Informatyki we współpracy z grupą naukowców z Uniwersytetu Jagiellońskiego opublikowali pracę "Continual Learning with Guarantees via Weight Interval Constraints" na konferencji ICML 2022 (International Conference on Machine Learning).

W pracy autorzy zaproponowali nowy rodzaj treningu, który daje pewne gwarancje w uczeniu ciągłym (ang. continual learning) sieci neuronowych. Współczesne metody ciągłego uczenia się skupiają się na efektywnym uczeniu sieci neuronowych ze strumienia danych, jednocześnie redukując negatywny wpływ katastrofalnego zapominania, ale nie dają żadnej solidnej gwarancji, że wydajność sieci nie ulegnie niekontrolowanemu pogorszeniu w czasie.

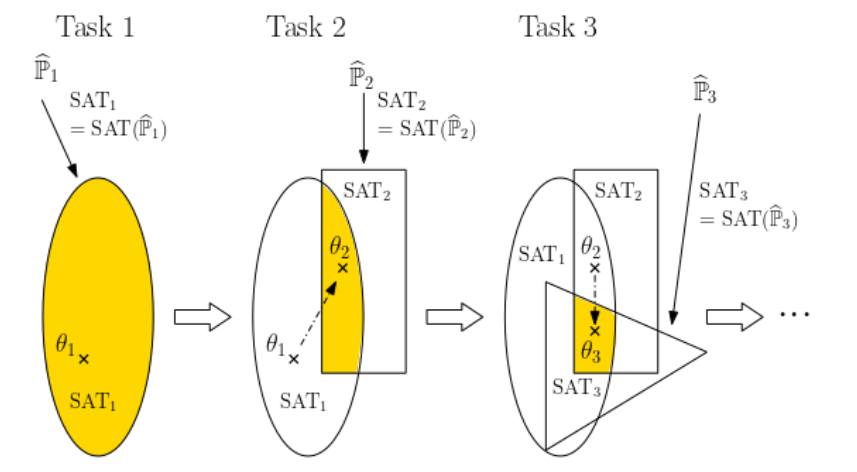

W pracy pokazano, jak ograniczyć zapominanie poprzez przeformułowanie ciągłego uczenia się modelu jako ciągłego skracania jego przestrzeni parametrów. W tym celu zaproponowano nową metodologię treningu, w której każde zadanie jest reprezentowane przez hiperprostokąt w przestrzeni parametrów, w pełni zawarty w hiperprostokątach poprzednich zadań. Ta formuła redukuje problem NP-trudny z powrotem do czasu wielomianowego, zapewniając jednocześnie odporność na zapominanie. Opublikowana praca może być punktem startowym do dalszych ulepszeń, w których trafność klasyfikacji byłaby lepsza przy zachowania gwarancji niezapominania.

Artykół dostępny jest na stronie Proceedings of Machine Learning Research Volume 162